Пентагон опубликовал проект морального кодекса по созданию искусственного интеллекта

Занимаясь поиском надежных и контролируемых технологий, Пентагон старается установить глобальные стандарты использования искусственного интеллекта (ИИ). На днях консультативной группой Пентагона опубликован долгожданный проект документа, выходящий за рамки аналогичных перечней принципов, уже обнародованных крупными технологическими компаниями.

Ключевыми понятиями нового кодекса являются: ответственность, объективность, контроль, надежность и управляемость.

В конце прошлого года руководители Пентагона попросили Совет по оборонным инновациям разработать список морально-этических принципов для ИИ. Совет привлек множество экспертов по правам человека, специалистов по компьютерной технике, инженеров, исследователей, лидеров гражданского общества, философов, инвесторов, бизнес-лидеров и служащих Пентагона, включая представителей Facebook, Microsoft, Google и других подобных компаний.

Ответственность формулируется максимально просто: «Люди должны проявлять мудрость и оставаться ответственными за разработку, развертывание, использование и результаты действий систем ИИ».

Объективность предписывает осторожность при построении наборов данных, используемых в машинном обучении, чтобы, как это часто случается, необъективные наборы данных не создали расистские или расово предвзятые алгоритмы.

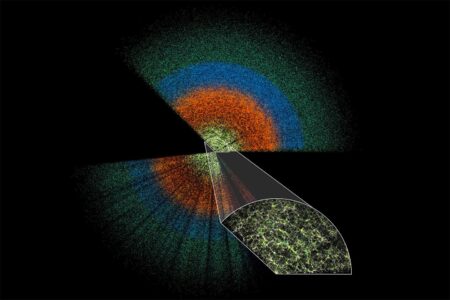

Контроль должен всегда позволять понять каким образом ИИ пришел к конкретному решению. Заявляется о необходимости в «проверяемости методологий, источников данных и процедур разработки и документации».

Надежность требует «явного и четкого определения области использования» и прохождения множества строгих тестов перед внедрением.

Управляемость подразумевает способность обнаружить и избежать нанесения непреднамеренного вреда: ИИ должен быть в состоянии остановить свою работу, если видит возможные проблемы от своих действий.

Руководство предполагает, что Пентагон должен обладать полным контролем над программным обеспечением ИИ: «не только проверка данных, но и кто имеет к ним доступ, для чего еще и кем используются эти модели и т.п.». Говорится, что перед каждым случаем использования ИИ не по прямому назначению, необходимо тщательное исследование целесообразности подобного использования и возможных последствий этого.

Проблема обеспечения надежности видится самой серьезной для Пентагона, поскольку предлагает совершенно новый режим тестирования нового программного обеспечения для обеспечения безопасности. Это потребует много времени и серьезных инвестиций.

Некоторые компании, такие как Google, Microsoft и Facebook, уже опубликовали свои собственные этические принципы для ИИ. Но их усилия не имели успеха. Google, например, после публикации своих принципов и созыва Совета по этике ИИ в апреле для определения насколько хорошо эти принципы соблюдаются, распустил Совет уже через неделю.

У Китая и России нет ничего, подобного этому выскокоморальному меморандуму. Вполне возможно наступит время, когда руководство Пентагона почувствует себя скованным этим кодексом. Но, в конце концов, для этого и разрабатывался документ. Пентагон не интересуют поражения в войнах, поэтому если Пентагон будет использовать ИИ опасными способами, нарушая рекомендации, это будет не потому, что у него не было правильных рекомендаций, а потому что он отказался их выполнять.

А всего 80 лет назад всё было намного проще и лаконичнее:

Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред.

Робот должен повиноваться всем приказам, которые даёт человек, кроме тех случаев, когда эти приказы противоречат Первому Закону.

Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому или Второму Законам.

/А. Азимов, 1942 г./